1.3 State Values and Bellman Equation (Action value and Summary)

Contents

前置知识

State Values and Bellman Equation (Basic and Definition) 1 State Values and Bellman Equation (Vector form 与 求解) 2

Action Value

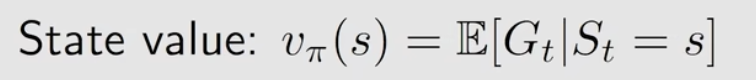

State Value: 从某个状态出发的average return

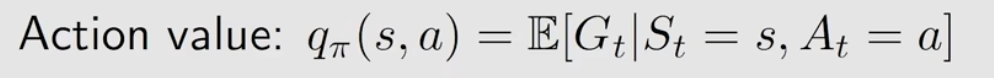

Action Value: 从某个状态出发,采取了某个action后的average return

可看到区别在于:Action value 是采取了某个action后,它的特点在于可以用于评估某个action的价值,从而使我们改进策略在的action,最终找到最优策略。

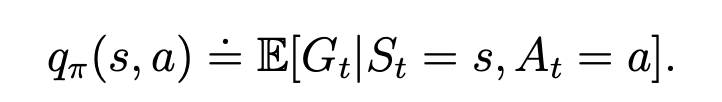

公式定义:

其中

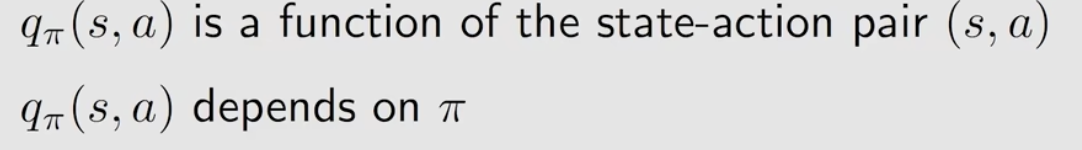

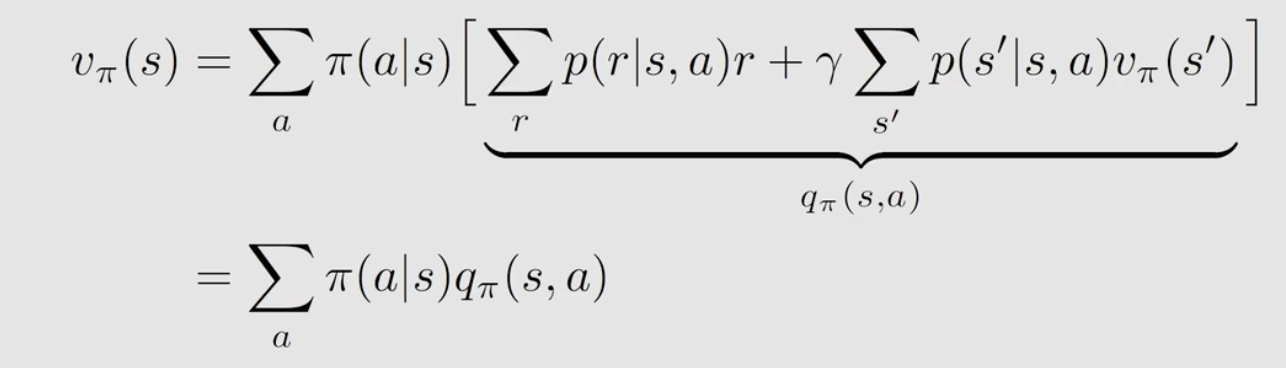

它与state value的关系 : 利用概率演变,当下状态的state value为取某一个action的概率乘以取这个action后的的state value,再求和。而 取这个action后的的state value 就是action value.

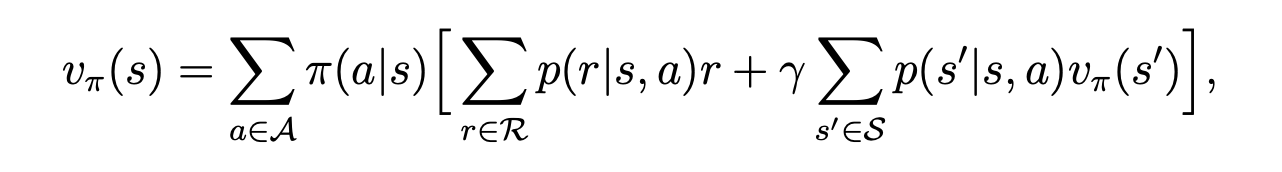

再看我们前面求的state value式子:

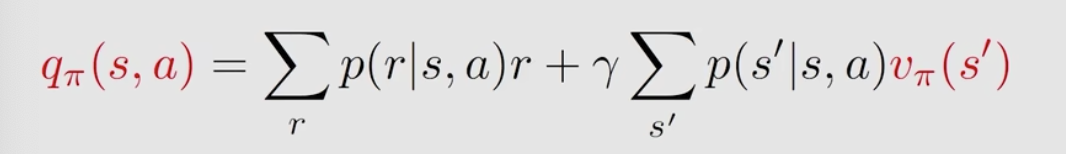

可见将公同的\(v_{\pi}(s)\)单拿出来即可得到action value的一个表达式:

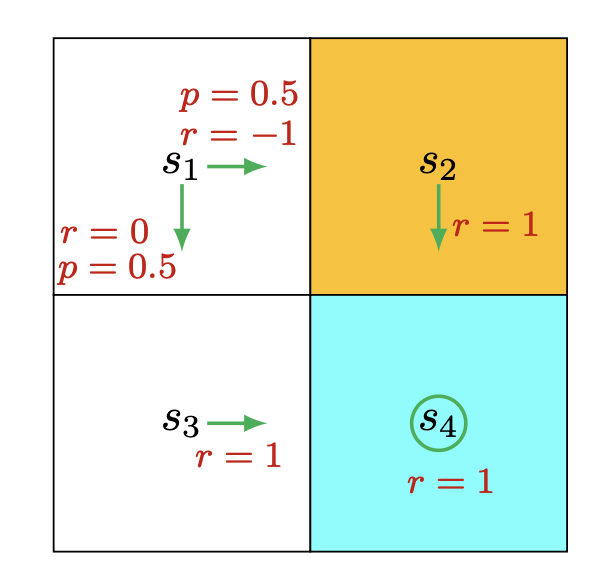

例子:

这个例子中,在状态s1时,分别计算2个action的action value:

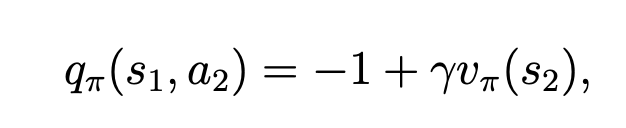

可以根据定义,action value为当下reward 加 下一个状态的state value, 因此a2为:

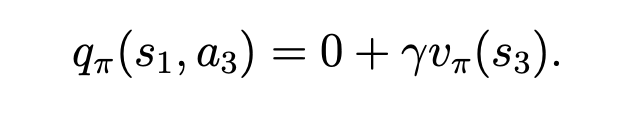

采用了 a2后会到达a3,而采用a2的收益是-1,因此得上述结果。同理,a3的 action value 为:

总结

-

state value

-

Action value

-

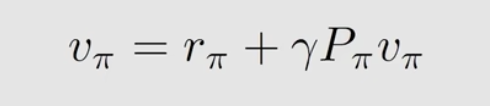

贝尔曼公式

-

贝尔曼公式的矩阵形式

-

贝尔曼公式的求解

-

直接求解(矩阵求逆)

-

迭代法

-

文若可采,幸赐清茗一盏,以助笔耕不辍